|

Realtà e Modelli Dalla

complessità alla progettualità: la via della comprensione.

Il

soggetto di un famosissimo quadro di Magritte è una pipa

fumante, il quadro contiene anche il titolo: “Questa non è

una pipa”. 1 - rappresentare la

realtà con un linguaggio formale e

comprensibile, di cui abbiamo totale padronanza e che quindi siamo in

grado di manipolare

2 - semplificare, sfrondare la rappresentazione da tutto ciò che è 1)inessenziale alla

comprensione

2)trascurabile per quanto riguarda gli effetti "Il

Libro dell'Universo è scritto in lingua matematica e i caratteri

sono triangoli, cerchi e altre figure geometriche, senza i quali

è impossibile intenderne umanamente parola"

Galileo Galilei (Il Saggiatore)

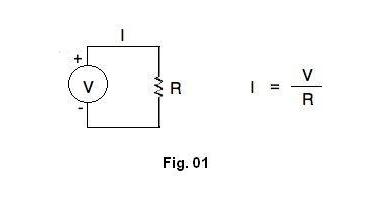

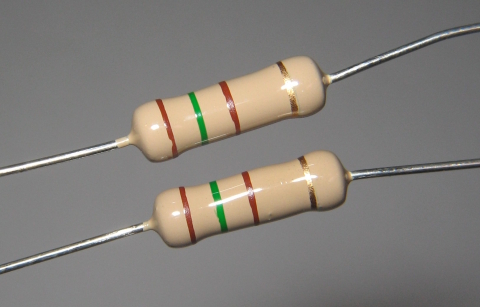

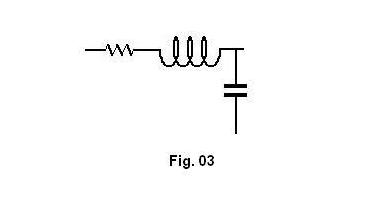

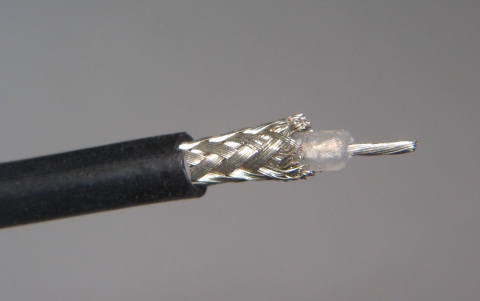

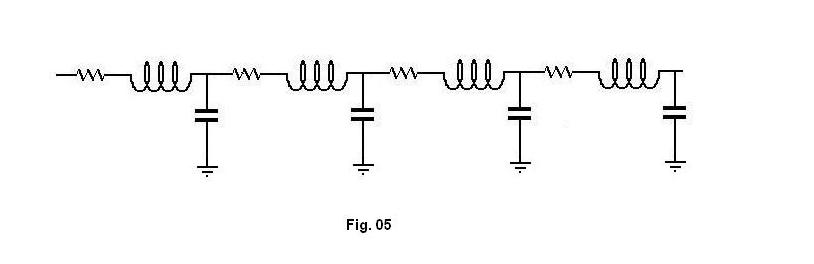

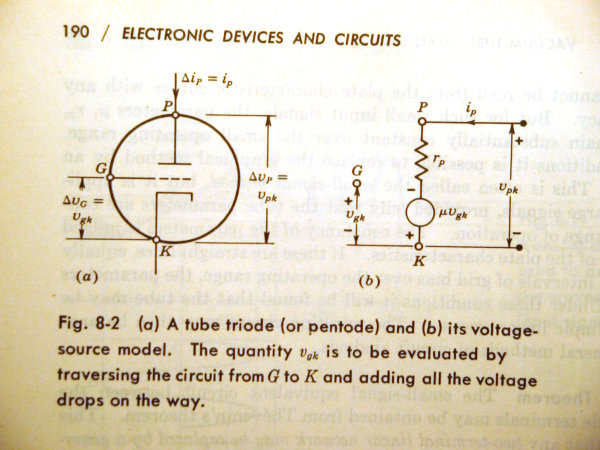

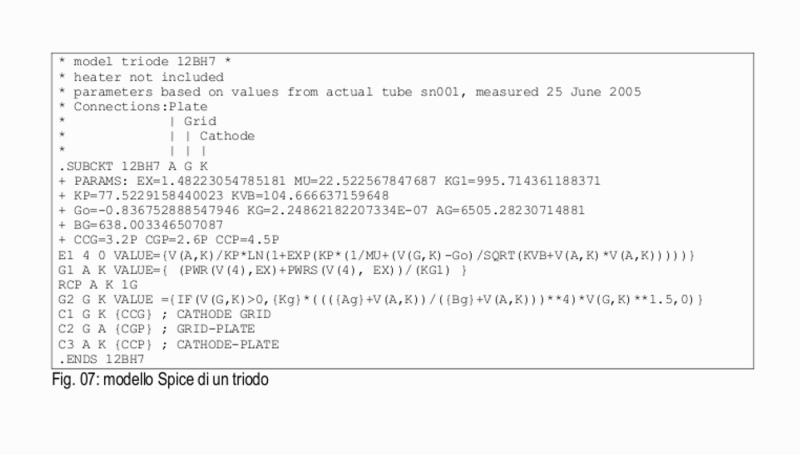

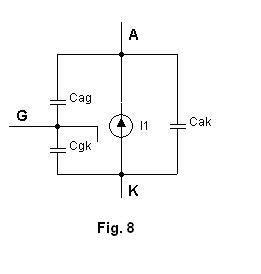

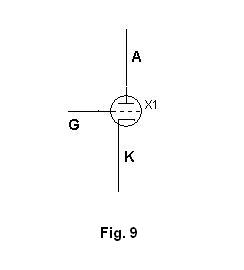

“Misurabili” significa che, diversamente dalla matematica pura, che ha come unico criterio di validità la coerenza e la non contraddittorietà, la matematica applicata alla realtà deve confrontarsi con la realtà stessa, cioè deve essere in grado di predire comportamenti concreti degli enti fisici, e noi dobbiamo confrontare la predizione (teoria) con ciò che è stato effettivamente rilevato (misura). Ma in realtà ogni volta che usiamo la matematica per descrivere una realtà fisica facciamo una serie non irrilevante di assunzioni, approssimazioni e semplificazioni: dall'assunzione di linearità e dal principio di sovrapponibilità (la somma degli effetti è uguale all'effetto della somma), alla esclusione di tutto ciò che complicherebbe eccessivamente la nostra rappresentazione: ciò porta a formulare leggi di cui nessuno mette in dubbio la validità ma che non è assolutamente possibile né verificare né falsificare rigorosamente. Mi spiego con un esempio semplicissimo: Completezza A rigor di logica per definire valido in toto un modello dovremmo porre tutte le domande possibili e confrontare con gli esperimenti tutte le risposte. Evidentemente ciò non è possibile, sia perché non sarebbe comunque possibile confrontarsi con il tutto, sia perché avendo operato una semplificazione, abbiamo a priori rinunciato a farlo. Le teorie scientifiche hanno l'ambizione di essere universali, e possono essere controllate solo indirettamente, sulla base delle loro conseguenze: le osservazioni sperimentali a favore di una teoria, per quanto numerose possano essere, non saranno mai tutte le verifiche possibili e quindi non potranno mai provarla definitivamente, mentre basta una sola prova contraria per confutarla (purché, come dicevo prima, sia riproducibile a piacere). Questo è il problema dell'induzione (detto anche “problema di Hume”): “siamo giustificati razionalmente a passare dai ripetuti esempi di cui abbiamo avuto esperienza agli esempi di cui non abbiamo avuto esperienza?”. In realtà la scienza non procede per induzione dai fatti alla teoria, ma inventa teorie mediante l'immaginazione e quindi le controlla mediante i fatti. Chiunque abbia esperienza di misure sa che se non c'è alla base una teoria non si sa cosa misurare. Il metodo scientifico oggi ha raggiunto coscienza che la verità assoluta non è alla nostra portata, ammesso che esista, quindi un modello viene considerato valido fino a che non venga rilevato qualche fatto che ne riveli i limiti. Coerenza Come si decide che la risposta R è coerente con i risultati sperimentali? Non è una domanda peregrina: abbiamo operato semplificazioni (deciso che cosa non è significativo o rilevante) ed approssimazioni (abbiamo deciso che cosa è trascurabile ed in che misura è trascurabile) nella costruzione del modello. Negli esperimenti abbiamo usato strumenti per compiere le misure; gli strumenti hanno una precisione definita ed una tolleranza: tre, quattro, comunque un numero finito di cifre per gli strumenti digitali, per lo meno lo spessore dell'ago per gli strumenti analogici, e l'esattezza è definita entro l' 1%, lo 0,1% ecc. a seconda della classe dello strumento (cioè dei soldi che siete disposti a investirci). Se ripetete dieci volte la stessa misura sugli stessi oggetti otterrete dieci risultati diversi, tutti distribuiti attorno ad un valore che viene definito il “risultato della misura”, e la distribuzione dei valori attorno al valore medio è espressa da una curva matematica che può essere una gaussiana (generalmente) o una laurenziana o qualche cosa di simile a seconda di cosa si sta misurando. Questo è esattamente l'esperimento che fisici ed ingegneri fanno il primo giorno del corso di “Teoria degli errori”, corso ponderoso, che dura un semestre e che insegna appunto a valutare la validità degli esperimenti. Che cosa è accettabile? Si tratta di decidere quali sono le semplificazioni e la tolleranza (margine di errore) accettabili. E' chiaro che nel momento in cui si rende disponibile uno strumento di misura più preciso, un nuovo esperimento può rivelare crepe nel modello che precedentemente non apparivano, in quanto celate dalla precisione disponibile. Quindi più si raffinano le misure più si richiedono modelli raffinati. E' però anche vero che la complessità del modello deve essere adeguata alla domanda cui deve rispondere: una carta topografica, che è il modello del territorio, al 25.000 è utile per una escursione in montagna, ma totalmente inutilizzabile per pianificare un viaggio da Milano a New York. Le considerazioni di completezza e di coerenza sono di natura diversa: la prima è di tipo ontologico e riguarda la verità, la seconda è di tipo pragmatico e riguarda l'utile. Sono comunque correlate, la conclusione è che non esiste la teoria o il modello assoluto, definitivo, il modello valido è quello che risponde alle domande che mi pongo in un momento ed in circostanze date (nota 1)(nota 2). Alcuni esempi Le considerazioni svolte finora non sono pura teoria che poco hanno a che vedere con la pratica dell'elettronica e dell'elettroacustica, che sono i campi di cui mi occupo qui. Analizziamo alcuni esempi per vedere come si applicano ai casi concreti. I componenti elementari ed i circuiti semplici Giusto per mettere i piedi per terra e cercare di concretizzare i discorsi fatti finora analizziamo l'esempio di modello per eccellenza (almeno nel campo che ci è più congeniale): lo schema elettrico di un circuito. La resistenza Partiamo da un esempio semplicissimo, quello di Fig 01 (attenzione, sembra banale, ma non lo è).  questo simbolo, che usiamo costantemente negli schemi elettrici dei nostri circuiti, è il modello teorico dell'oggetto di Fig.02.  E' evidente (o almeno, lo è a chiunque legga uno schema elettrico capendo come funziona), che il modello della resistenza non consiste “solo” nello zig-zag: lo zig-zag è la rappresentazione (nel senso di Magritte) di un fenomeno fisico, la cui espressione più semplice è data dalla legge di Ohm: I = V / R 1.0 ciò significa che quando disegniamo, nello schema, lo zig-zag, intendiamo un dispositivo che quando ai suoi capi viene applicata una tensione continua V, esso è attraversato da una corrente I, ed il rapporto fra V ed I è la caratteristica identificativa del dispositivo, il suo valore resistivo R. In altre parole quando nello schema disegniamo lo zig-zag intendiamo in realtà rappresentare una legge fisica ed una caratteristica fisica del dispositivo che intendiamo usare. Lo stesso concetto vale per il condensatore: V = Q / C 1.1 (il condensatore è un dispositivo che quando ai suoi capi è applicata una tensione V si carica di una quantità di carica elettrica Q) e considerazioni analoghe si possono fare per altri dispositivi. Semplice? solo in apparenza, o meglio, in prima approssimazione. A parte il fatto che sotto una semplice striscia a zig-zag c'è un bel po' di leggi fisiche, e senza quelle leggi fisiche il nostro simbolo a zig-zag sarebbe del tutto inutile, tant'è vero che qualsiasi schema elettrico acquista un senso solo quando si hanno ben presenti almeno la legge di Ohm e quelle di Kirchoff (e per il momento ci limitiamo alla corrente continua), in realtà il nostro modello, fintanto che si limita alla legge della 1.0), è decisamente incompleto. Mi spiego: il modello, se assumiamo che la 1.0) sia la sua espressione matematica, presume che R sia costante, ma ciò, se vogliamo essere “pignoli”, cioè non ci accontentiamo della “prima approssimazione”, non è vero. La resistenza di un dispositivo fisico “resistore” reale dipende sia dalla temperatura sia dalla tensione applicata ai suoi capi, quindi un modello teorico più completo sarebbe in realtà: I = V / ( R * f(T,V) ) 1.3) dove f(T,V) è una qualche funzione della temperatura T e della tensione V che assume il valore 1 per T = 25°C (per convenzione, oppure 20°C) e per tensione V = 0, e che per temperatura costante = 25°C si discosta abbastanza poco da 1, almeno fino a tensioni inferiori alla tensione limite del resistore in oggetto, mentre per tensione nulla si discosta in misura variabile da 1 a seconda della tecnologia costruttiva del resistore stesso (la dipendenza di R dalla temperatura fa parte delle caratteristiche tecniche del dispositivo). A titolo di esempio, il simulatore Spice MicroCap (che è un manipolatore di modelli) permette di tener conto, nella simulazione di un resistore, dei seguenti effetti: Tc1 coefficiente lineare di temperatura Tc2 coefficiente quadratico di temperatura o in alternativa Tce coefficiente esponenziale di temperatura per cui ad esempio nel primo caso R' = R * ( 1 + Tc1*(T-Tnom)+Tc2*(T-Tnom)^2) e nel secondo caso R' = R * 1.01^(Tce*(T-Tnom)) mentre non tiene conto dell'effetto “tensione”, per restare nel campo della corrente continua; permette altresì di utilizzare un coefficiente di rumore e una funzione della frequenza, quando si vada alla corrente alternata. Vi sembra ancora così semplice? Ed abbiamo appena cominciato. Quanto detto finora vale nel caso di corrente continua, nel caso di corrente alternata dobbiamo anche tener conto della tecnologia costruttiva e di alcuni semplici concetti fisici. Le normali resistenze (tranne le vecchie resistenze ad impasto) sono costruite mediante un deposito più o meno sottile di un materiale conduttore dotato di resistività elevata (strato di carbone o ossidi metallici) su un cilindretto di ceramica, inciso a spirale mediante un raggio laser da una macchina a controllo automatico, per ottenere automaticamente il valore desiderato. Inciso a spirale significa che il dispositivo ha una induttanza propria non sempre trascurabile, e necessariamente una capacità, per quanto ridotta, fra le spire. Inoltre una volta montato in circuito c'è una capacità verso massa e verso gli altri componenti, ed anche i due fili che collegano il materiale resistivo hanno una loro induttanza, come per altro una loro resistenza. Quindi un modello più completo di un resistore montato in circuito potrebbe essere quello di fig 3.  Dico “potrebbe” in quanto qualsiasi modello è necessariamente “a costanti concentrate”. “A costanti concentrate” significa che le componenti “parassite” sono rappresentate mediante componenti discreti, mentre nella realtà fisica sono “distribuite” lungo i fili, fra le spire ecc. In termini più precisi, un modello a costanti concentrate è significativo quando la distribuzione spaziale dell'energia elettromagnetica è irrilevante rispetto al funzionamento del circuito, mentre quando la distribuzione spaziale dell'energia elettromagnetica è rilevante non si può più ragionare in termini di “costanti concentrate” ma bisogna ragionare in termini di “costanti distribuite” (cioè tener conto della distribuzione dell'energia nello spazio): per risolvere questi problemi i modelli semplici non sono sufficienti e si deve ricorrere alla forma canonica delle equazioni di Maxwell, alla teoria dei campi ecc. Un modello a costanti distribuite è indispensabile quando la lunghezza d'onda del segnale trattato è confrontabile con le dimensioni fisiche del dispositivo. Rappresentare un sistema fisico reale mediante le equazioni di Maxwell o la teoria generale del campo elettromagnetico non è affatto semplice: pensate alla soluzione concreta, mediante la legge di gravitazione universale, del campo gravitazionale di una mela reale che cade da un albero reale, tenendo conto che la mela è attratta dalla terra, dalla testa di Isacco Newton, dall'albero da cui cade, dalla luna, dal sole ecc. Però un modello pratico di un circuito “a costanti distribuite” non è praticamente costruibile e maneggiabile. La linea di trasmissione Facciamo l'esempio di un cavo coassiale: un filo conduttore inserito in un cilindro esterno conduttore ed isolato da questo mediante un apposito materiale isolante, ad esempio un tipico RG58U come in fig 4.  E' noto che un cavo coassiale ha una sua impedenza caratteristica, nel caso dell'RG58U essa è pari a 52 ohm: ciò significa che un cavo di lunghezza infinita si comporta come una resistenza da 52 ohm (stiamo ovviamente parlando di alte frequenze). E' ovvio che il nostro cavo non potrà mai essere di lunghezza infinita, ma se uno spezzone di cavo di qualsiasi lunghezza viene terminato ad una estremità con una resistenza pari alla sua impedenza caratteristica, dall'altra estremità viene “visto” come se fosse di lunghezza infinita (a questo proposito è interessante rileggere un articolo su Costruire HiFi n 103 del solito Bartolomeo Aloia – “solito” nel senso che ogni articolo di Aloia è di livello qualitativo immenso; gli articoli di Aloia si leggono proficuamente per puro interesse culturale, anche quando non si ha un interesse immediato all'argomento insegnano sempre qualche cosa di utile). Il comportamento del cavo è determinato dalla capacità e dall'induttanza distribuite lungo il cavo: due cilindri concentrici formano un condensatore, e due conduttori affiancati formano una induttanza; noi potremmo parlare di capacità per metro o induttanza per metro quindi rappresentare il cavo con un modello come in fig 5.  Ma il modello non è corretto: se costruiamo un modello fisico di cavo con componenti discreti, cioè condensatori di capacità pari alla capacità per metro del cavo, induttori di valore pari all'induttanza per metro del cavo, connessi con spezzoni di cavo normale (unipolare, per essere chiari) lunghi un metro, e ne uniamo un po', sicuramente non otteniamo un oggetto dalla impedenza caratteristica del nostro cavo. Il cavo coassiale si comporta così perché induttanza e capacità sono per così dire “spalmate” uniformemente per ogni decimillimetro o milionesimo di millimetro del cavo. Quanto contano questi effetti? possiamo trascurarli? E' la nostra domanda iniziale: chi decide che cosa è trascurabile nel modello e che cosa è rilevante? Dipende da che cosa stiamo trattando, non c'è una risposta univoca: a 1000 MHz un cm di differenza nella lunghezza di un conduttore è sicuramente determinante (il circuito potrebbe benissimo non funzionare), mentre se ci stiamo occupando di basse frequenze le capacità ed induttanze parassite possono essere trascurabili. O forse no: c'è chi si preoccupa dell'induttanza parassita dei resistori nei circuiti HiFi, e se il circuito è costruito con operazionali a larga banda, o anche solo con semiconduttori con frequenze di taglio elevate ed il circuito fa uso di controreazione, probabilmente fa bene a preoccuparsi; in questo caso anche il solo layout del circuito stampato può influire anche pesantemente sul funzionamento. Quindi la risposta è che non esiste “il” modello, esistono vari modelli ciascuno adeguato ad un problema. La qual cosa era già implicita nella definizione iniziale: “ data una realtà X problematica, cioè questa realtà ci pone una domanda Q......ecc ”: si costruisce il modello M adeguato alla domanda Q, non ha senso costruire un modello inutilmente complesso. Se mi sto occupando di corrente continua (e non uso circuiti con controreazione) non metto le capacità parassite nel modello. E' ovvio che non è mai così semplice, decidere se inserire qualche elemento nel modello non ha mai una risposta univoca, spesso si deve fare un compromesso fra rigore e praticità, in pratica la scelta è responsabilità del progettista e deve essere “verificata”, nel senso che solo l'analisi sperimentale condotta seriamente ci dice dove cessa la validità del modello, fino a dove è utilizzabile e da quale punto deve essere migliorato o sostituito. Il triodo. Un modello valido per piccoli segnali e a corrente quasi continua è in Fig. 6.  riportato a pag. 190 di “Electronic devices and circuits” (Millman & Halkias, ed. McGrow – Hill, 1966): l'autore per così dire mette le mani avanti, delimitando a priori l'ambito di validità del modello che propone. Come si vede vengono totalmente trascurati gli elementi sensibili alla frequenza, cioè le capacità parassite, d'altra parte ciò è perfettamente coerente con la premessa. Vediamo il modello Spice di un triodo :  (Il simulatore Spice ovviamente non maneggia disegni, ma relazioni matematiche ). Il modello Spice si traduce graficamente come in fig 8,

anche se qualsiasi simulatore con interfaccia grafica lo mostra come in fig 9, non mostra cioè gli elementi “parassiti” (e in realtà il modello grafico non mostra nemmeno la dipendenza della corrente dalla tensione: è come la resistenza, lo “zig—zag” ha senso solo se “sotto” presupponiamo la legge di Ohm). Le righe contrassegnate da “+” definiscono i valori numerici dei parametri utilizzati nelle righe successive, le righe E1, G1 e G2 definiscono le “leggi” matematiche utilizzate, le righe C1, C2 e C3 definiscono le capacità parassite fra rispettivamente griglia e catodo, griglia e anodo, anodo e catodo. Le capacità parassite non influenzano il funzionamento in CC definito dalle righe E1, G1 e G2, ma il comportamento del triodo nel circuito in cui è inserito (come è giusto). E' interessante la riga “RCP A K 1G” la quale inserisce nel modello una resistenza di un gigaohm (1012 ohm) fra anodo e catodo per “chiudere” il circuito: Spice non “digerisce” circuiti in cui non passi alcuna corrente. Le righe E1, G1 e G2 definiscono una legge di funzionamento che non è ricavata analiticamente, ma include fattori correttivi impostati empiricamente per ottenere un funzionamento del modello corrispondente a quello effettivo della 12BH7. I modelli più semplici di triodi, quelli usati in origine nei simulatori Spice, erano derivati dal modello base di Reynolds e Leach, a loro volta basati sulla legge di Langmuir – Child: Ip = K * (mu * Vgk + Vpk) ^ 1.5. La legge è ricavata dalla fisica di base degli elettroni in un campo elettrico, ed è un po' come la legge di gravitazione universale, vale perfettamente solo in condizioni ideali: elettrodi di superficie infinita, piatti, con emissione costante di elettroni, con una griglia ideale che crea un campo elettrico uniforme, nel vuoto assoluto. E' chiaro che questa legge non tiene conto della costituzione fisica reale di una valvola reale. Non tieno conto per lo meno: della

dipendenza della emissione di elettroni dalla temperatura e struttura

del catodo o dalla distribuzione del potenziale lungo il filamento, a

seconda che parliamo di valvole a riscaldamento indiretto o diretto.

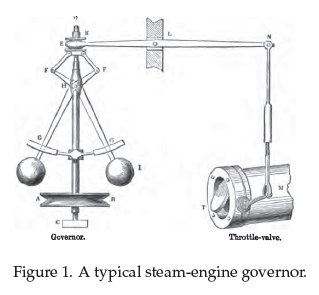

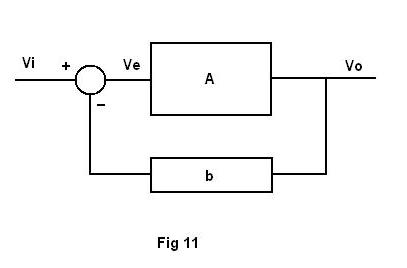

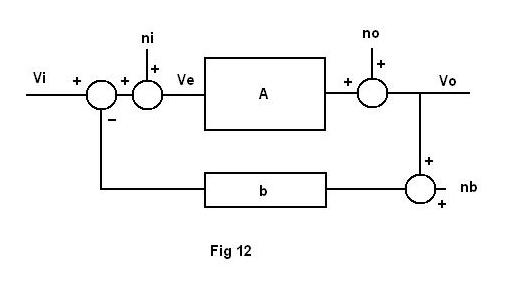

del potenziale di contatto dei gas (residui) presenti nel bulbo della velocità iniziale degli elettroni (che in certo qual modo è correlata a quanto detto al punto a), ma non solo.) dello spessore e della distanza reciproca dei fili che costiruiscono la griglia I modelli più usati di recente derivano dagli studi di Norman Koren, e per quanto basati in linea di massima sulla legge di Langmuir - Child, inseriscono una serie di fattori correttivi che non derivano dalla teoria, ma sono empirici, trovati per tentativi. Il merito fondamentale di Norman Koren è stato, in parallelo alla formulazione dei correttivi, la messa a punto di precise metodologie di misura per la determinazione dei coefficienti. I modelli di questo genere si definiscono “fenomenologici”. Il modello di Fig. 7 è appunto un modello di Norman Koren. Possiamo dire che la teoria è indispensabile, senza la teoria di base del moto degli elettroni in un campo elettrico non saremmo andati lontano, ma la soluzione del problema reale, la valvola 12BH7 (o qualsiasi altra) richiede un modello pratico. Questo è un altro modo di affrontare la dicotomia teoria – modello. La mia impressione, ma non ci ho meditato abbastanza quindi resta solo una impressione, è che più le dimensioni fisiche della valvola diminuiscono più il modello si complica; il modello di una 845 richiede meno correttivi di una 6DJ8. La controreazione concludo con una disquisizione puramente teorica sul modello più generale della reazione negativa.  La controreazione non è una esclusiva dei circuiti elettronici: in fig.10 si vede un bellissimo esempio di reazione negativa in un sistema meccanico, che ha lo scopo di regolare e stabilizzare la velocità di rotazione di una macchina a vapore. Il modello generale di un sistema con controreazione è in fig.11.  Il funzionamento del modello è troppo noto perché serva spendere più di tante parole. Il confronto fra il segnale di ingresso ed il segnale di uscita attenuato dal circuito di controreazione assicura le note caratteristiche: la desensibilizzazione, che è la riduzione della dipendenza del sistema (cioè con la controreazione applicata) dai parametri fisici del blocco attivo (privo di controreazione), purché il guadagno del blocco attivo sia abbastanza elevato ( A >> 1/b): dato che a questo mondo nulla è gratis ciò si ottiene al prezzo di una considerevole riduzione del guadagno ad anello chiuso, che risulta pari circa ad 1/b. In compenso, dato che in genere il circuito di controreazione è passivo, è incomparabilmente più stabile del blocco attivo, quindi il guadagno si riduce sì a 1/b, ma con una stabilità (quasi) di roccia. la linearizzazione, che è la trasformazione in (quasi) una retta della funzione di trasferimento del sistema, mentre in genere la funzione di trasferimento del blocco attivo una retta non lo è. In altre parole si ha la riduzione della distorsione del blocco attivo. Il primo limite che balza all'occhio è che sia la desensibilizzazione che la linearizzazione dipendono dalla differenza fra il guadagno ad anello aperto ed il guadagno ad anello chiuso, ma questo non è un vero problema, oggi. Gli altri “limiti” della controreazione sono noti già da prima dell'era elettronica: possibile instabilità ecc., e non è difficile venirne a capo (se li conosci li eviti). Ma c'è un limite molto più subdolo del modello, che si “nasconde” nelle definizioni che abbiamo dato ma appare chiaramente ad una analisi attenta del modello nella sua veste grafica. Abbiamo parlato di desensibilizzazione e linearizzazione del sistema rispetto alle caratteristiche del blocco attivo, abbiamo parlato della stabilità (e data per scontata la linearità) del circuito di controreazione, in quanto costituito da elementi passivi, ma.... e il differenziatore ce lo siamo proprio dimenticato? Tutti i ragionamenti fatti finora, tutte le formule semplici basate sul modello semplice (il modello generale è molto semplice) si basano su un assunto che è tutto da verificare, che per certe applicazioni o rispetto a certi parametri è del tutto irrilevante, ma per altre applicazioni o rispetto ad altri parametri potrebbe non esserlo affatto. L'assunzione cui mi riferisco è quella, su cui si basa tutto il modello semplice, che il differenziatore sia perfetto, che per esso il principio di sovrapposizione si applichi senza discussione, cioè che sia perfettamente lineare, in altre parole che il segnale di errore Ve sia costituito solo dalla differenza fra Vi e Vb. Ma nessun circuito attivo, ed il differenziatore è assolutamente un circuito attivo, è lineare. Allora, per capire che effetti può avere la non linearità del differenziatore dobbiamo complicarci la vita, e per sgomberare il campo da incertezze sul funzionamento dei simulatori (ho già affermato varie volte che trovo Spice “un po' ottimista” per quanto attiene alla linearità dei dispositivi, ma in realtà questo dipende solo dalla semplicità dei modelli che diamo in pasto a Spice) si deve partire dalla teoria: non avrebbe proprio senso indagare sulla validità di un modello in condizioni limite usando un simulatore, che a sua volta fa uso dei modelli di cui dobbiamo (o almeno, io voglio) controllare la validità ed i limiti di applicabilità. Dobbiamo quindi indagare sull'influenza dei disturbi “esterni” sul sistema, quindi dobbiamo integrare il nostro modello teorico con qualche cosa che ne tenga conto. Come vedrete anche in questo caso complichiamo il modello, ma in realtà pur complicandolo facciamo ulteriori semplificazioni: d'altra parte stiamo indagando proprio su quegli effetti “di ordine superiore” che nella prima analisi abbiamo ritenuto opportuno trattare come irrilevanti. Semplificando molto, possiamo dire che i nostri disturbi “esterni” possono influire in tre punti: all'ingresso del blocco attivo

all'uscita del blocco attivo all'ingresso del circuito di controreazione come in fig.12  dove ni rappresenta i disturbi “iniettati” all'ingresso del blocco attivo, no i disturbi all'uscita del blocco attivo, nb i disturbi all'ingresso del circuito di controreazione. Applicando i calcoli canonici della controreazione vediamo che il segnale di errore (che è quello amplificato dal blocco attivo) è dato da: Ve = Vi + ni - b*(Vo + nb) 2.1) e anche, tenendo conto del raffinamento del modello: Vo = Ve * A + no 2.2) combinando la 2.1) con la 2.2) otteniamo: Vo = (Vi + ni) * A / ( 1 + A*b ) - nb * A*b / ( 1 + A*b ) + no * 1 / ( 1 + A*b ) 2.3) Il terzo termine ci dice che i disturbi all'uscita del blocco attivo sono attenuati considerevolmente: dato che no rappresenta i disturbi generati dal blocco attivo, ciò non ci dice nulla di nuovo. Il secondo termine ci dice che i disturbi all'ingresso del circuito di controreazione restano sostanzialmente invariati: dato che nb rappresenta i disturbi del circuito di controreazione, anche questo non ci dice nulla di nuovo. Inoltre, dato che il circuito di controreazione è essenzialmente passivo, con molta probabilità ci troviamo di fronte solo ad un basso rumore termico. Il primo termine ci dice che il disturbo all'ingresso del blocco attivo è indistinguibile dal segnale di ingresso, quindi viene amplificato assieme e nella stessa misura. (nota 3) Ma che cosa è il disturbo all'ingresso del blocco attivo se non il disturbo generato dal differenziatore? Ora immaginiamo di avere un segnale Vi di frequenza f0: Vi = V(f0) all'uscita del differenziatore ci troviamo un segnale che in più dell'originale ha un contributo: ni = k2* V(2f0) + k3 * V(3f0) + k4 * V(4f0) +....... dove k2, k3, k4 .... sono coefficienti numerici minori di 1 che dipendono dalla non linearità del differenziatore: in altre parole la distorsione prodotta dal differenziatore. La 2.3) ci dice che la distorsione introdotta dal differenziatore non viene attenuata dalla controreazione. Quindi dal punto di vista della distorsione tutta la qualità del sistema è determinata dalla qualità del differenziatore. Una ipotesi da controllare teoricamente sarebbe anche la seguente: che cosa succede alle componenti della distorsione che vengono amplificate per un fattore A , quindi attenuate per un fattore b e quindi si ripresentano all'ingresso del sistema? forse ciascuna subisce la stessa sorte del segnale Vi, generando ulteriori contributi di distorsione, e dando origine ad un sottofondo di livello bassissimo (quanto basso, dipende dalla qualità del differenziatore) ma di ordine elevatissimo? Ora, è difficile modellizzare, e cioè quantificare, la non linearità del differenziatore, quindi questo discorso rimane, come avevo premesso e per quanto mi interessa al momento, puramente teorico, nel senso che non ho un modello realmente utilizzabile per ottenere risultati pratici, però una cosa rimane certa: che un modello solo (il modello “semplice”) non basta. Se devo studiare il guadagno, la stabilizzazione, o anche la linearizzazione ad un livello “grossolano” (passatemi il termine), allora il modello semplice va più che bene e non serve complicarsi la vita. Ma se devo lavorare sulle distorsioni in seconda, terza quarta ecc approssimazione allora il modello semplice, che tratta solo le distorsioni del blocco attivo, come se il differenziatore non esistesse, sicuramente non basta; almeno a livello teorico devo ricordarmi che il modello deve essere diverso. Poi sono abbastanza sicuro che un differenziatore realizzato bene con una 6SN7, oppure con un differenziale a FET alimentato a corrente costante e caricato con specchio di corrente, siano molto lineari, ma non posso fingere con ciò che il problema non esista. Per tornare all'inizio, ogni realtà problematica pone le sue domande, e per ogni domanda c'è il suo modello, o magari anche più di uno. Conclusioni. Una sola: i modelli servono se usati con cognizione di causa (tanto per cambiare, nulla di nuovo) e finisco citando per l'ultima volta Karl Popper: “ogni

qualvolta una teoria ti sembra essere l'unica possibile, prendilo come

un segno che non hai capito né la teoria né il problema

che si intendeva risolvere”

Karl Popper (Conoscenza oggettiva: un punto di vista evoluzionistico) Note Nota 1: in questa ottica i modelli di Aristotele non erano errati: erano validi in quanto rispondevano alle domande che era concettualmente possibile porsi ai suoi tempi. Il modello Tolemaico permetteva di prevedere con notevole esattezza i movimenti degli astri noti al suo tempo, quindi non era errato, bensì valido in quelle condizioni di conoscenza scientifica; ciò che era fondamentalmente errato era pensare che fosse la verità assoluta, l'unica teoria possibile, ma anche questo errore deriva dalle condizioni culturali del periodo. Nota 2: quindi un criterio “furbo” per decidere quanto raffinare un modello è il seguente: quando hai raggiunto i risultati che vuoi, fermati, se continui a raffinare non sai cosa potrebbe succedere. Nota 3: tratto da “Appunti di elettronica” del Prof. G.V. Pallottino, Dipartimento di Fisica, Università La Sapienza, Roma. |

|

|

|||

| Home | Progetti | ||